PyTorch 中的原生支援

PyTorch 透過 torch.onnx API 包含對 ONNX 的支援,以簡化將 PyTorch 模型匯出到可移植的 ONNX 格式。ONNX Runtime 團隊維護這些匯出器 API,以確保與 PyTorch 模型的高度相容性。

import torch

torch.onnx.export(

model,

inputs,

"model.onnx")

PyTorch 以其易於理解和靈活的 API、大量的現成模型(尤其是在自然語言處理 (NLP) 領域)以及其領域特定庫,引領著深度學習領域。

在雲、桌面、移動裝置、物聯網甚至瀏覽器中執行 PyTorch 模型

加速 PyTorch 模型以改善使用者體驗並降低成本

被 Microsoft 和許多其他公司用於其生產環境中的 PyTorch 工作負載

PyTorch 透過 torch.onnx API 包含對 ONNX 的支援,以簡化將 PyTorch 模型匯出到可移植的 ONNX 格式。ONNX Runtime 團隊維護這些匯出器 API,以確保與 PyTorch 模型的高度相容性。

import torch

torch.onnx.export(

model,

inputs,

"model.onnx")

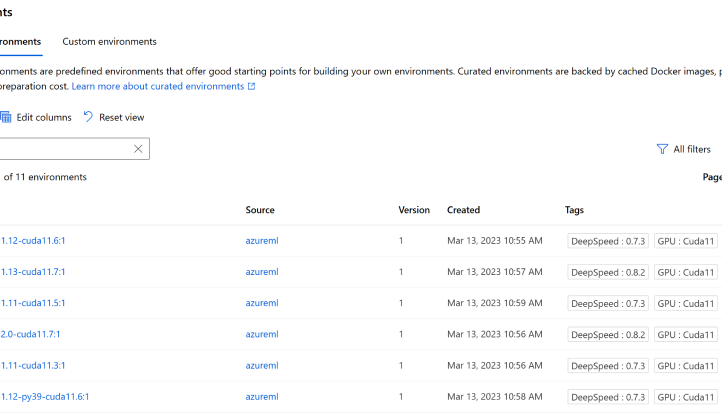

在 Azure Machine Learning 中使用內建的 PyTorch 環境,可靠且大規模地訓練和部署模型,確保透過一個輕量級、獨立的、包含 ONNX Runtime for Training 等所需元件的環境,全面支援最新版本的 PyTorch,從而有效執行大型模型的最佳化訓練。

更好的效能有助於改善使用者體驗並降低運營成本。從計算機視覺(ResNet、MobileNet、Inception、YOLO、超解析度等)到語音和 NLP(BERT、RoBERTa、GPT-2、T5 等)的各種模型都可以從 ONNX Runtime 的最佳化效能中受益。ONNX Runtime 團隊定期對熱門模型進行基準測試和效能最佳化。ONNX Runtime 還集成了 TensorRT 和 OpenVINO 等頂尖硬體加速器庫,因此您可以在所有目標平臺上使用相同的通用 API,同時在可用硬體上獲得最佳效能。

開發敏捷性是總成本的關鍵因素。ONNX Runtime 是基於將 PyTorch 模型投入 Microsoft Office、Bing 和 Azure 等高規模服務的生產環境的經驗而構建的。過去,將模型從研發 (R&D) 投入生產需要數週甚至數月。藉助 ONNX Runtime,模型可以在數小時或數天內準備好大規模部署。